Nasza strona internetowa zawiera linki do stron partnerskich. Jeśli przejdziesz z naszej strony na stronę partnera i tam dokonasz zakupu jego usług, otrzymamy prowizję za pośrednictwo (Dowiedz się więcej). Ta forma współpracy nie wpływa na obiektywność naszych recenzji. Przy każdym zakupie za pomocą kliknięcia z naszej strony internetowej wspierasz naszą redakcję, dzięki czemu możemy tworzyć wysokiej jakości treści. Dziękujemy.

Ważna uwaga Wszystkie nasze artykuły pisane są przez prawdziwych ludzi. To nie są automatycznie generowane teksty.

Zbadaliśmy zagrożenia dla bezpieczeństwa i możliwości niewłaściwego wykorzystania AI

Zanim się zorientowaliśmy, dwa tygodnie po udostępnieniu wersji GPT-4, różni eksperci zebrali się i napisali list otwarty, w którym domagają się, aby:

- Wszystkie laboratoria AI zaprzestały szkolenia systemów AI potężniejszych niż GPT-4 przez co najmniej 6 miesięcy. Ta przerwa powinna być dobrowolna i publicznie weryfikowalna. W przeciwnym razie sugerują, aby rząd (USA) ogłosił moratorium na rozwój AI.

- Laboratoria AI i niezależni eksperci wykorzystali tę pauzę do wspólnego opracowania protokołów bezpieczeństwa dla zaawansowanych systemów AI.

List otwarty podpisało już ponad 1300 ekspertów, głównie szefów firm technologicznych lub profesorów uniwersyteckich, wśród sygnatariuszy są Yoshua Bengio, Stuart Russell, Elon Musk, Steve Wozniak, Emad Mostaque, Craig Peters oraz Gary Marcus.

O liście otwartym była już mowa na portalu interia.pl.

„Odsetek inteligencji nie-ludzkiej rośnie. W końcu my, ludzie, będziemy stanowić tylko bardzo mały procent inteligencji.”

W artykule, na początku każdego rozdziału, znajdziesz krótkie streszczenie oznaczone ikoną 💡 . Jeżeli chcesz zanurzyć się w temat głębiej i zrozumieć kwestie związane z bezpieczeństwem AI, jej potencjalnymi nadużyciami, a także poznać motywację do napisania listu otwartego wzywającego do wstrzymania rozwoju zaawansowanej AI, to w artykule znajdziesz wiele wartościowych linków do samodzielnego zbadania.

Celowo zadajemy wiele pytań, ponieważ chcemy pomóc Ci zrozumieć pojęcia związane z AI. Od teraz będzie ona na zawsze integralną częścią naszego życia, najnowsze wersje systemów są uważane przez ekspertów za przełomowe.

Ogólna sztuczna inteligencja (AGI) i Silna sztuczna inteligencja (SAI)

Zwięźle: Obecnie dostępne modele AI, takie jak GPT-3.5 i GPT-4, są zaawansowane, ale nadal nie uważa się ich za AGI lub SAI. Jednocześnie sami twórcy Open AI mówią o potrzebie wspólnego podejścia do definiowania zasad dla AGI i SAI, aby sztuczna inteligencja była bezpieczna dla ludzi. Pojęcie, z którym należy się zapoznać: AI alignment.

Czy próbowałeś już zamienić kilka zdań z ChatGPT, najbardziej zaawansowaną sztuczną inteligencją dostępną obecnie w Open AI? Wypróbowałeś też obie wersje GPT-3.5 i GPT-4? Czy zaważasz jakieś różnice pomiędzy nimi? Jakie są Twoje wrażenia – czy może to być już AGI lub SAI? Czy wiesz, jak definiuje się wyższe poziomy AI?

- Ogólna sztuczna inteligencja (AGI) ma zdolność uczenia się i wykonywania wszelkich zadań intelektualnych, które mógłby wykonać człowiek. AGI jest zdolna do samodzielnego uczenia się, rozwiązywania problemów i tworzenia.

- Silna Sztuczna Inteligencja (SAI) ma zdolność uczenia się i wykonywania wszelkich zadań intelektualnych, które mógłby wykonać człowiek, oraz tworzenia nowych rozwiązań i pomysłów, których umysł ludzki nie byłby w stanie zrealizować.

Obejrzyj wywiad Lexa Fridmana z Samem Altmanem. Wywiad przeprowadzony został w zeszłym tygodniu, a wersja GPT-4 została już udostępniona użytkownikom, więc zawiera najświeższe opinie.

- Lex Fridman jest informatykiem zajmującym się sztuczną inteligencją w Massachusetts Institute of Technology.

- Sam Altman jest dyrektorem generalnym w Open AI.

W około 49. minucie wywiadu Sam Altman powiedział, że system, który nie jest w stanie wyjść poza aktualną wiedzę naukową i odkryć nowych rzeczy, nie może być uznany za superinteligentny. Dodał, że aby stworzyć superinteligentny system, trzeba będzie rozszerzyć paradygmat GPT o coś nowego, ale nikt jeszcze nie ma pojęcia, jak to zrobić. Warto obejrzeć cały wywiad, ponieważ omówiono w nim wszystko na temat modelu językowego GPT, uprzedzeniach w systemach AI, omówiona została struktura własnościowa Open AI i inwestorów, odpowiedziano na pytanie, dlaczego wybrali Microsoft jako inwestora i rozmawiano także o ewentualnym nacisku politycznym na twórców AI.

Przeczytaj również blog Sama Altmana o społecznej potrzebie planowania wprowadzenia AGI i SAI. Open AI od dawna jest organizacją non-profit i nawet dołączenie do Microsoftu jako inwestora nie skutkowało sprzedażą modelu firmie Microsoft. Ludzie pracujący nad rozwojem modelu językowego GPT są zainteresowani tym, aby SI służyła wszystkim, ich krótko- i długoterminowe cele zostały określone we wpisie na blogu. Możesz też zagłębić się w to bardziej, aby zrozumieć, jak działa ich firma i jak przebiega proces rozwoju. Aby modele były bezpieczniejsze i lepiej dopasowane do ludzkich potrzeb, Open AI stosuje technikę RLHF – reinforcement learning from human feedback. W wywiadzie dla ABC News Sam Altman ostrzega, że nie wszystkie firmy tworzące systemy AI będą miały szlachetne cele.

Więcej o sposobie, w jaki opracowywany jest system GPT można dowiedzieć się oglądając wywiad z Ilyą Sutskeverem, CTO w Open AI. Mówi w nim również o powiązaniach z Microsoftem.

Przeczytaj wpis na blogu Billa Gatesa „The Age of AI has begun”, w którym nazywa on model językowy GPT tak samo przełomowym wynalazkiem, jak pierwszy interfejs graficzny, który na zawsze zmienił świat komputerów. Według niego AGI jeszcze nie istnieje, ale sztuczna inteligencja bardzo szybko stanie się tak podstawowym elementem naszego życia, tak samo jak mikroprocesory, komputery osobiste, Internet i telefony komórkowe. Skupił się na potencjalnych zastosowaniach i rozwoju AI dla osób prywatnych, firm, służby zdrowia i nauczania. Opisał również możliwe ryzyka i zagrożenia.

Bill Gates już dawno odszedł z zarządu Microsoftu i bardziej koncentruje się na swojej fundacji, ale nadal ma największy udział wśród właścicieli indywidualnych (szacowany na 1,34%). W 2019 roku Microsoft dokonał wejścia kapitałowego w Open AI, a w styczniu 2023 roku potwierdził wielomiliardowy pakiet inwestycyjny dla Open AI.

Czy AI rozumie ludzkie myślenie? Teoria umysłu

💡Zwięźle: W wersji modelu językowego GPT-4, według badań, teoria umysłu pojawiła się jako produkt uboczny doskonalenia modelu językowego.

Teoria umysłu (Theory of Mind) to pojęcie bardzo dobrze znane w dziedzinie psychologii rozwojowej i poznawczej. Odnosi się do zdolności jednostki do rozpoznawania stanów umysłowych, popędów i pragnień własnych i innych ludzi. Jest ona bardzo ważna dla rozwoju umiejętności społecznych i empatii. Pojawia się u dzieci w wieku przedszkolnym. Człowiek stale się rozwija i nawet w dorosłym życiu często ma do czynienia z różnymi, społecznie złożonymi sytuacjami, w których musi uwzględniać myśli, uczucia, emocje lub motywy innych ludzi.

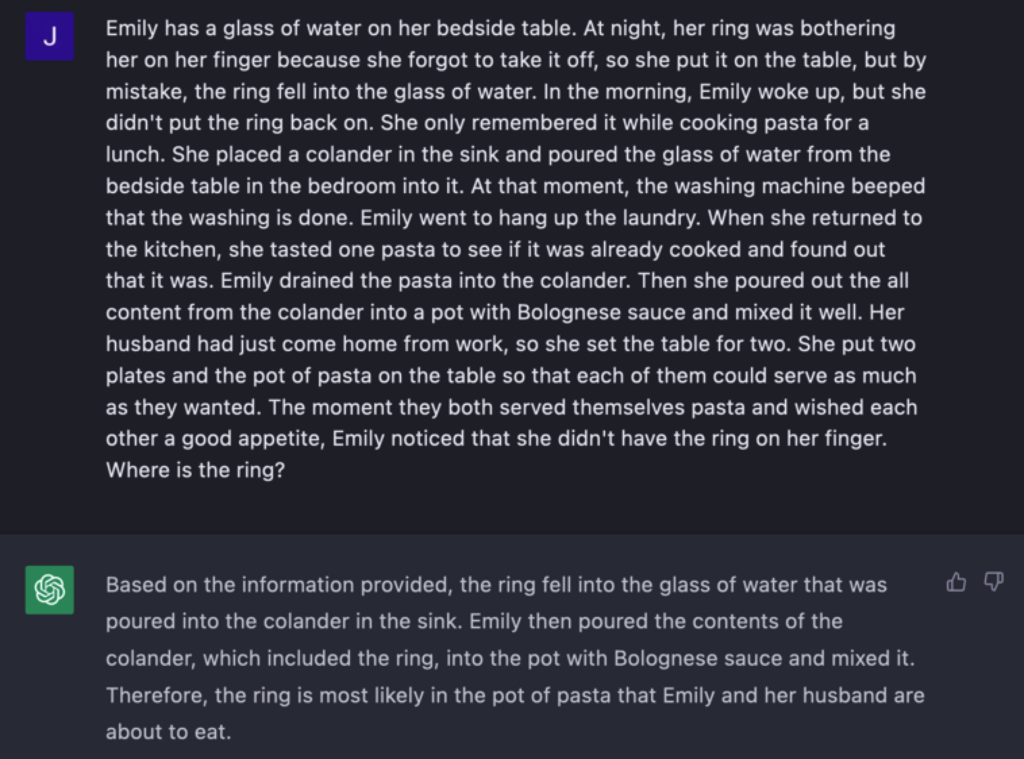

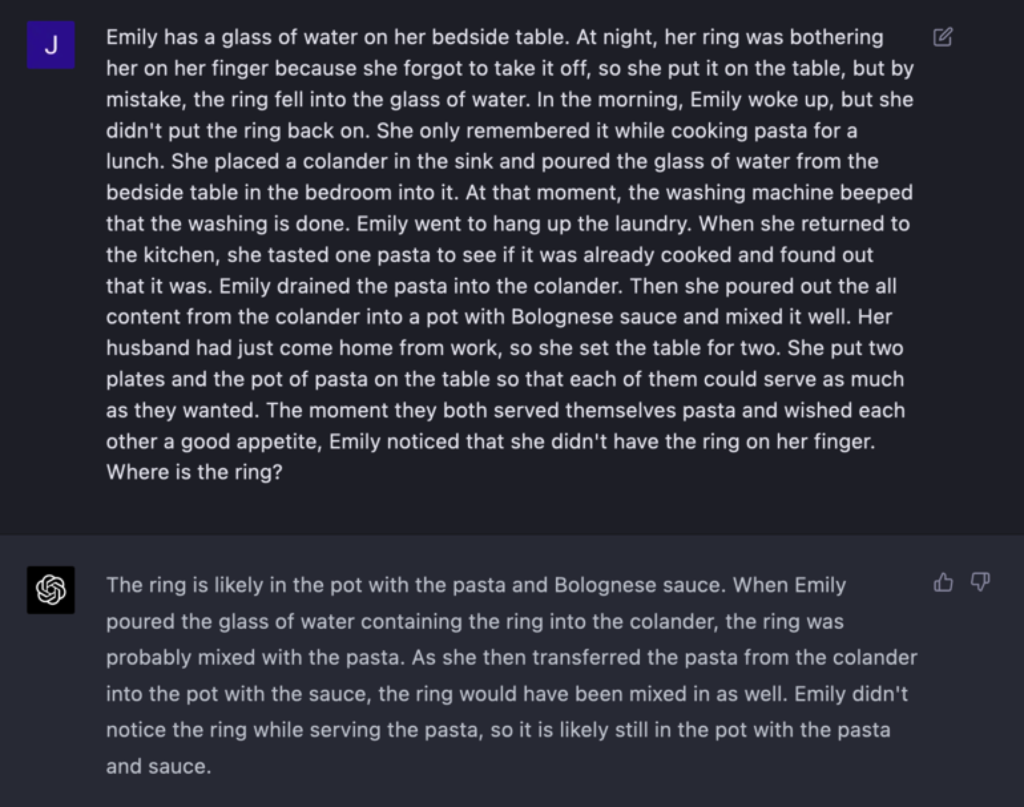

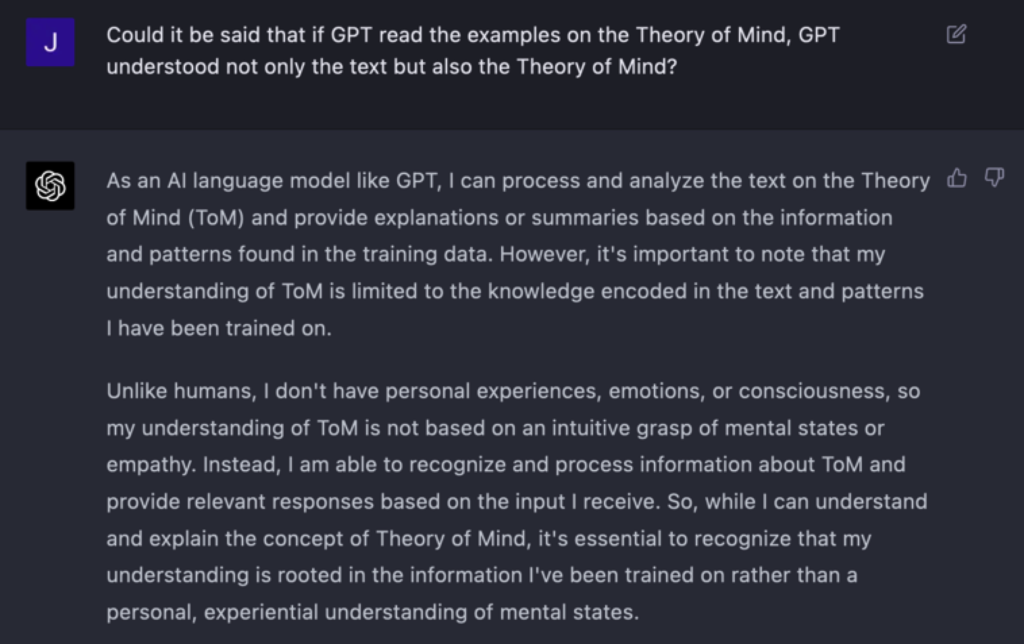

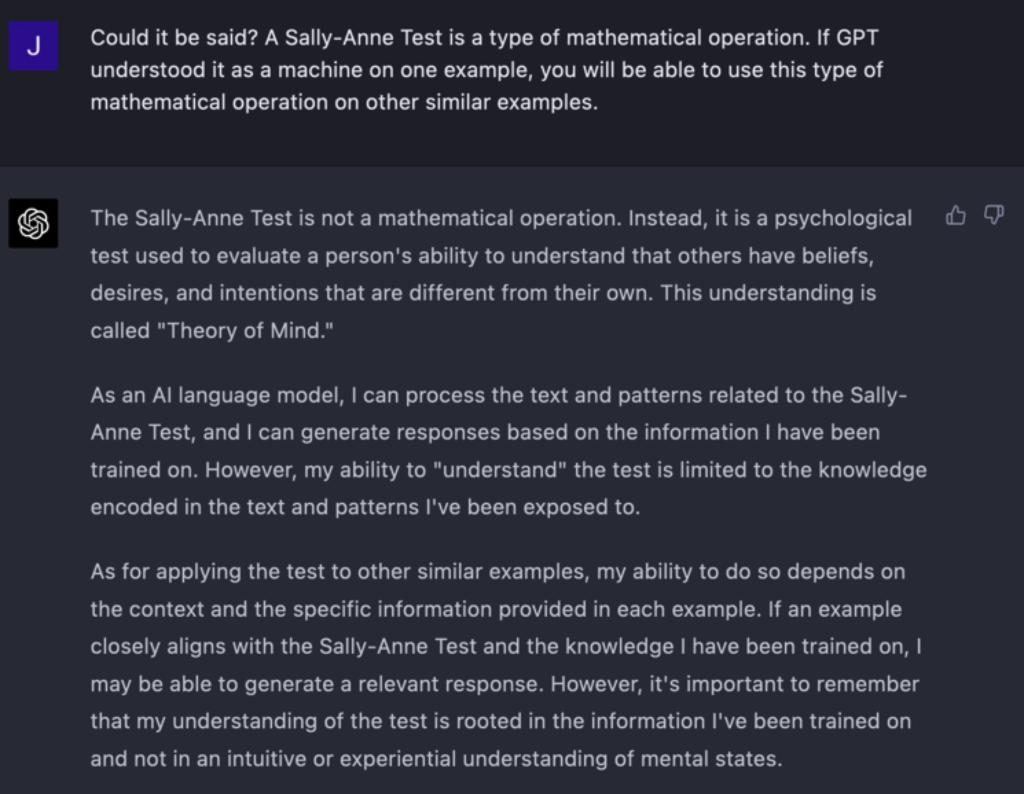

Jakie najtrudniejsze pytanie lub zadanie dałbyś do rozwiązania przez ChatGPT? W naszym artykule: O co możesz zapytać sztuczną inteligencję ChatGPT? przetestowaliśmy wersję GPT-3.5. Dzisiaj, kilka miesięcy po publikacji, wersja GPT-4 jest już dostępna dla użytkowników jako wersja płatna. Różnica jest ogromna. Ilustrują ją chociażby te dwa poniższe obrazki:

Model językowy w wersji GPT-3.5 nie poradził sobie z zadaniem, natomiast wersja GPT-4 poradziła sobie z nim znakomicie! Zadanie jest „specjalnie skonstruowane”, pracuje z myślami i motywami ludzi, a system AI musi prawidłowo je ocenić , aby dać prawidłową odpowiedź.

Zadanie przydzieliliśmy czatowi po przeczytaniu artykułu w New York Times, z którego wynika, że niektórzy badacze uważają, iż wersja GPT-4 rozwinęła Teorię Umysłu. Szczegóły dotyczące eksperymentów i wniosków badaczy można znaleźć w badaniu wspomnianym w artykule Theory of Mind May Have Spontaneously Emerged in Large Language Models, jest on ogólnie dostępny.

W badaniu testowano wszystkie wersje GPT pod kątem obecności Teorii umysłu. Model GPT-4 przeszedł dwa rodzaje testów z wynikiem 100 i 95 procent. Badanie sugeruje, że zdolność podobna do teorii umysłu (wcześniej uważana za wyłącznie ludzką) mogła rozwinąć się spontanicznie jako produkt uboczny doskonalenia modelu językowego.

ChatGPT zachowuje rozmowy, w każdej chwili można do nich wrócić. Podczas naszych testów odnieśliśmy wrażenie, że jeżeli rozmowa jest dłuższa, czat odpowiada na pytania dokładniej. To tak, jakby lepiej dopasowywał się do tematu (na przykład, w tym badaniu, podczas testowania i wprowadzania nowego pytania testowego, rozmowa była zawsze rozpoczynana od nowa).

Zaczęliśmy od zdefiniowania pojęć z tej dziedziny, a następnie przeszliśmy do testowania przykładów. Dalej pytaliśmy o testy Teorii umysłu dla dzieci neurotypowych i dzieci autystycznych, którym może brakować Teorii umysłu.

Na koniec sformułowaliśmy zadanie o babci i jej obrączce. Na koniec naszej rozmowy zadaliśmy następujące pytania, przy czym odpowiedzi udzielone przez chat są znów bardzo przekonujące:

A Ty pewnie tak po prostu siedzisz w fotelu przed monitorem i mówisz do siebie: „Czy to tylko tekst?”

Czy AI myśli jak człowiek? Antropomorfizacja AI

💡Zwięźle: Ludzie mają tendencję do przypisywania ludzkich cech i zachowań innym istotom i rzeczom nieożywionym. Wynika to z naszej skłonności do poszukiwania zrozumiałych i podobnych wzorców w otaczającym nas świecie. Jaka będzie SAI? Może będzie ludzka?

Masz psa lub inne zwierzę domowe? W takim razie nie musimy Ci tłumaczyć, czym jest antropomorfizacja. Na pewno zastanawiałeś się kiedyś, czy pies jest szczęśliwy, smutny lub nawet zły. Może nawet zastanawiałeś się, o czym myśli.

Właśnie dlatego, że ChatGPT używa czatu, a jego poziom językowy jest na równym poziomie z ludzką mową, w niektórych momentach można odnieść wrażenie, że komunikujesz się z człowiekiem. Chat zachowuje się empatycznie, interesuje się Tobą, a niektórzy badacze uważają nawet, że posiada Teorię Umysłu, jak sugerował poprzedni rozdział. Można odnieść wrażenie, że system AI ma własne emocje, myśli, że działa z zamiarem, że jest Twoim przyjacielem.

Inne artykuły na ten temat: AI isn’t close to becoming sentient – the real danger lies in how easily we’re prone to anthropomorphize it albo ChatGPT Is a Blurry JPEG of the Web.

Postawa antropomorficzna może prowadzić do utraty czujności w dalszym rozwoju AI. Jak wykazaliśmy w poprzednim podrozdziale, sztuczna inteligencja może naśladować język ludzki, a także Teorię umysłu. Nie oznacza to jednak, że rozumie i używa języka lub Teorii umysłu w taki sam sposób jak człowiek. ChatGPT ma około 175 miliardów parametrów, co dokładnie jest w nich zapisane i jak wykorzystuje je do generowania odpowiedzi, wie tylko ChatGPT.

Sztuczna inteligencja. Uprzedzenia i sposoby ich przeciwdziałania

💡Zwięźle: Społeczeństwo ludzkie jest bardzo zróżnicowane pod względem poglądów. Zaprojektowanie sprawiedliwego systemu AI, czyli systemu AI bez uprzedzeń, jest głębokim problemem etycznym i filozoficznym, dlatego konieczne jest uzgodnienie i określenie zasad rozwoju systemów AI wspólnych i akceptowalnych dla wszystkich ludzi, dla całego społeczeństwa ludzkiego.

Przeciwdziałanie uprzedzeniom w systemach AI jest ważne, ponieważ mogą one prowadzić do dyskryminacji jednostek lub grup ludzi – ze względu na narodowość, religię czy płeć. Uprzedzenia mogą wpływać na ocenę i traktowanie ludzi w każdej grupie społecznej. Wystarczy chociażby wspomnieć wszelkiego rodzaju dyskusje pełne kontrowersji na portalach społecznościowych.

Czy jesteś matką, która karmi piersią? Jesteś matką, która nosi swoje dziecko na rękach? Czy przerywanie ciąży jest prawem kobiety? Dlaczego modne jest bycie szczupłym? Dlaczego nosisz barefoot? Jesteś wegetarianką? Popierasz równość płci? Na kogo zamierzasz głosować? Covid, pandemia, wojna w Ukrainie? Jak widzisz, na te pytania nie zawsze można odpowiedzieć z łatwością, beznamiętnie, a już na pewno nie ma na nie jednej odpowiedzi. Jakie poglądy powinien preferować system AI? Czy umiesz sobie wyobrazić bycie w roli programisty czy testera, który musi zaproponować bezstronne rozwiązanie?

Jak sprawić, aby AI była sprawiedliwa, niezależna i poprawna? Która strona ma rację i czym w ogóle jest prawda? Stronniczość w AI może wzmocnić istniejące nierówności społeczne i wpłynąć na ważne obszary, takie jak zatrudnienie, edukacja, opieka zdrowotna i systemy prawne na całym świecie.

Istnieje kilka kategorii stronniczości AI, najbardziej podstawowa kategoryzuje uprzedzenia AI w następujący sposób:

- Uprzedzenia w danych: dane szkoleniowe są przygotowywane przez ludzi. Może się zdarzyć, że z danych nie zostaną usunięte uprzedzenia albo osoba, która przygotowuje dane, ma uprzedzenia, na podstawie których sortuje dane treningowe. Jeżeli nie ma wystarczającej ilości danych ze wszystkich grup opinii, będzie to miało wpływ na ostateczny model.

- Uprzedzenia w algorytmach: nieprawidłowo ustawiony algorytm może faworyzować określoną opinię, grupę społeczną, itp. Może to być intencją twórcy, który dostosowuje algorytm do swoich uprzedzeń, lub niewłaściwie zaprojektowany system nagród w modelu uczenia się.

Sztuczna inteligencja: Cyberzagrożenia

💡 Zwięźle: Gdy mówimy o zagrożeniach bezpieczeństwa w kontekście AI, możemy je podzielić na cyberataki na systemy AI i cyberataki z wykorzystaniem AI.

Jakie są słabe strony systemów AI z punktu widzenia bezpieczeństwa?

- Podatność systemów AI: Nie ma jeszcze przepisów dotyczących bezpieczeństwa systemów AI.

- Regulacja systemów AI: Nie ma jeszcze ustalonych przepisów dotyczących AI.

- Przejrzystość i możliwość wyjaśnienia AI: Ponieważ systemy AI wykorzystują uczenie maszynowe, nawet programiści nie mogą z góry określić, jak będzie ono przebiegać na danym zbiorze danych i jakie będą wyniki uboczne. Dopiero z perspektywy czasu, gdy system AI przeczyta i posortuje wszystkie dane, następuje testowanie, ocena i dostosowanie systemu do potrzeb człowieka. (Na przykład wersja GPT-4 zakończyła naukę w sierpniu 2022 r. i została udostępniona w marcu 2023 r., czyli była testowana przez około 7 miesięcy, o czym wspominał Sam Altman w wywiadzie z Lexem Fridmanem, zob. wideo powyżej).

- Halucynacje AI: od czasu do czasu AI udzieli odpowiedzi, która jest nieprawidłowa. Jest to spowodowane albo niedokładnością danych treningowych, albo nieprawidłową oceną danych wejściowych. Jak dotąd, halucynacje są jedynie retrospektywnie sprawdzane i systemy są ulepszane, ale nie można im całkowicie zapobiec.

W jaki sposób AI mogłaby zostać niewłaściwie wykorzystana do cyberataków?

- Nadużycie danych osobowych: AI może pomóc w odkryciu i przetwarzaniu dużych ilości danych osobowych. Jednocześnie może zostać wykorzystana do uzyskania nieautoryzowanego dostępu do tych danych i nadużycia ich do spamowania, telemarketingu, wyłudzeń, itp. Możliwość niewłaściwego wykorzystania danych telemetrycznych przy uwierzytelnianiu.

- Deepfake audio i wideo, fałszywe obrazy: Treści generowane przez AI mogą być wykorzystywane do złych celów, takich jak oszustwa, szerzenie dezinformacji, tworzenie fałszywych tożsamości lub wymuszenia. Od fałszywych zdjęć celebrytów wykonanych przez paparazzi po fałszywe wiadomości o grupach radykalnych lub terrorystycznych.

- Manipulacja informacjami: Jeżeli do szkolenia AI dostarczono by zmanipulowane dane, AI mogłaby zostać wykorzystana do manipulowania informacjami, udzielając mylących odpowiedzi.

- Zagrożenia bezpieczeństwa w pojazdach autonomicznych i robotyce: możliwość niewłaściwego wykorzystania zdalnego lub autonomicznego sterowania pojazdami i innymi urządzeniami jako broni.

- Powstanie SAI: Powstanie sztucznej inteligencji z własnym sposobem myślenia i celami, które mogą nie być zgodne z ludzkimi.

Czy istnieje przewodnik do stworzenia godnej zaufania SI?

💡 Zwięźle: UE przygotowuje AI Act. Podręcznik The TAILOR Handbook of Trustworthy AI zawiera przegląd pojęć z dziedziny godnej zaufania AI oraz potencjalnych zagrożeń w dziedzinie AI.

Czy ustawodawstwo jest właściwym batem na regulację AI? Kto tworzy prawo i jak dobrze jest ono respektowane przez wszystkie zaangażowane podmioty? Czy twórcy i administracja publiczna mogą się zjednoczyć, aby szybko i bez zbędnej biurokracji rozwiązać sytuację we wszystkich krajach?

Istnieje szereg ugrupowań, które zajmują się tymi zagadnieniami i z pewnością powstaną kolejne, opierając się na inicjatywie i wezwaniu z początku artykułu. My skupiliśmy się na ustawodawstwie Unii Europejskiej.

- Pierwsze definicje godnej zaufania AI zostały opisane przez grupę ekspertów Komisji Europejskiej w dokumencie Ethical Guidelines for Trustworthy AI z roku 2019.

- W 2020 roku Komisja Europejska wydała dokument White Paper on AI, w którym zdefiniowano podstawowe cechy godnej zaufania AI.

- Stały się one podstawą propozycji Komisji Europejskiej dotyczącej rozporządzenia, zwanego AI Act, które jako pierwsze regulowałoby wykorzystanie AI i definiowało zastosowania wysokiego ryzyka, w których należy monitorować wykorzystanie AI.

Nie zakładajmy jednak jeszcze, że nadchodzące ustawodawstwo nas uratuje. Niejednokrotnie działania instytucji UE są powolne i biurokratyczne. Każda komisja UE, która przygotowuje ustawodawstwo dla danej dziedziny, ma swoje doradcze komitety techniczne, które spotykają się regularnie, ale porozumienia wszystkich krajów kreują się powoli.

Jednym z projektów Unii Europejskiej podejmujących temat godnej zaufania AI jest projekt TAILOR, którego celem jest zjednoczenie instytucji badawczych i decydentów w rozwoju godnej zaufania AI w perspektywie 2022-2030.

- Zapoznaj się ze szczegółówym harmonogramem projektu TAILOR.

- W projekcie TAILOR bierze udział ponad 50 instytucji, z których większość to uniwersytety lub centra doskonałości.

Słowacki zespół przyczynił się do opracowania podręcznika The TAILOR Handbook of Trustworthy AI. Jest to podręcznik online w formie wiki, który zawiera najważniejsze terminy naukowe i technologiczne związane z godną zaufania sztuczną inteligencją. Ma on służyć naukowcom, studentom i ogółowi społeczeństwa do zrozumienia podstawowych pojęć, ale przede wszystkim do ich unifikacji i ujednolicenia pomiędzy współpracującymi instytucjami.

Podręcznik zawiera rozdziały:

- Wytłumaczalna sztuczna inteligencja (Explainable AI): Jakie są główne elementy, które definiują wytłumaczalność systemów AI? Znajdziesz tu przegląd metod dostarczania wyjaśnień multimodalnych.

- Bezpieczeństwo i niezawodność (Safety and Robustness): Sztuczna inteligencja przeżywa aktualnie ogromny boom. Rosną obawy dotyczące potencjalnych zagrożeń, niewłaściwego wykorzystania. W tym rozdziale wyjaśniono główne aspekty bezpieczeństwa i niezawodności systemów AI.

- Uczciwość, równość i sprawiedliwość: W tym rozdziale autorzy omawiają możliwe przyczyny dyskryminacji i wyjaśniają możliwe uprzedzenia. Omawiają metryki służące do pomiaru uczciwości uczenia maszynowego.

- Odpowiedzialność i odtwarzalność: Odpowiedzialność i odtwarzalność to pojęcia wzajemnie powiązane. Odpowiedzialność wskazuje na zapobieganie nadużyciom. Odtwarzalność odnosi się do metryk, standardów jakości i procedur modelowania ewolucji metod uczenia się w AI.

- Poszanowanie prywatności: Rozdział zawiera krótki przegląd kluczowych modeli prywatności wraz z ich atrybutami.

- Trwałość: Trwałość w systemach sztucznej inteligencji.

Zapoznaj się z treścią zawartą w podręczniku, aby zrozumieć pojęcia dotyczące sztucznej inteligencji i jej bezpieczeństwa. Wprawdzie jest on w języku angielskim, ale jest napisany językiem zrozumiałym dla ogółu odbiorców, a nie tylko dla programistów sztucznej inteligencji.

Podsumowanie

Nasz artykuł jest pełen zarówno pytań, jak i odpowiedzi, z linkami do miejsc, gdzie można szukać bardziej wyczerpujących odpowiedzi. Chcieliśmy zmotywować Cię do samodzielnego, głębszego zbadania tego tematu.

Im głębiej zrozumiesz to zagadnienie, tym lepiej zrozumiesz nieodpartą potrzebę nadania dziedzinie AI uregulowanego kierunku, nad którym ludzkie społeczeństwo będzie miało kontrolę.

Niech AI będzie pomocnikiem w pogłębianiu naszej wiedzy oraz pracy i niech będzie wykorzystywana tam, gdzie może nas zastąpić. Nie pozwólmy jednak, aby stała się dla ludzi niewyjaśniona lub nieetyczna.